Tin tức Napatech

Giới thiệu giải pháp Napatech Infrastructure Processing Unit (IPU) của Napatech

Giải pháp Napatech Infrastructure Processing Unit (IPU) tối đa hóa hiệu suất của mạng lưới trung tâm dữ liệu cho các nền tảng Infrastructure-as-a-Service

Các nhà điều hành trung tâm dữ liệu doanh nghiệp và đám mây liên tục phải đối mặt với thách thức là tối đa hóa hiệu suất tính toán và bảo mật dữ liệu có sẵn cho các ứng dụng của bên thuê, đồng thời giảm thiểu tổng thể CAPEX, OPEX và mức tiêu thụ năng lượng của nền tảng Cơ sở hạ tầng dưới dạng dịch vụ (IaaS) của họ. Tuy nhiên, cơ sở hạ tầng mạng trung tâm dữ liệu truyền thống dựa trên Thẻ giao diện mạng (NIC) tiêu chuẩn hoặc “nền tảng” áp đặt các hạn chế về cả hiệu suất và bảo mật bằng cách chạy ngăn xếp mạng trên CPU máy chủ lưu trữ, cũng như các dịch vụ liên quan như trình quản lý ảo.

Bản tóm tắt giải pháp này giải thích cách giải pháp phần cứng cộng với phần mềm tích hợp từ Napatech giải quyết vấn đề này bằng cách chuyển tải ngăn xếp mạng từ CPU máy chủ sang Đơn vị xử lý cơ sở hạ tầng (IPU) trong khi vẫn duy trì khả năng tương thích hoàn toàn của phần mềm ở cấp ứng dụng.

Giải pháp này không chỉ giải phóng các lõi CPU của máy chủ mà nếu không sẽ bị tiêu thụ bởi các chức năng mạng mà còn mang lại hiệu suất mặt phẳng dữ liệu cao hơn đáng kể so với mạng dựa trên phần mềm, đạt được mức hiệu suất mà nếu không sẽ yêu cầu các máy chủ đắt tiền hơn với CPU cao cấp hơn. Điều này làm giảm đáng kể CAPEX, OPEX và mức tiêu thụ năng lượng của trung tâm dữ liệu.

Kiến trúc dựa trên IPU cũng đưa một lớp bảo mật vào hệ thống, cô lập quá trình xử lý cơ sở hạ tầng cấp hệ thống khỏi các ứng dụng và khối lượng công việc tạo ra doanh thu. Điều này làm tăng khả năng bảo vệ chống lại các cuộc tấn công mạng, giúp giảm khả năng trung tâm dữ liệu bị vi phạm bảo mật và dữ liệu khách hàng có giá trị cao bị xâm phạm, đồng thời cho phép khách hàng kiểm soát hoàn toàn các tài nguyên hệ thống máy chủ.

Cuối cùng, việc chuyển giao các dịch vụ cơ sở hạ tầng như ngăn xếp mạng và trình quản lý ảo sang IPU cho phép các nhà điều hành trung tâm dữ liệu đạt được tính linh hoạt trong triển khai và khả năng mở rộng thường liên quan đến Phiên bản máy chủ ảo (VSI), đồng thời đảm bảo các lợi ích về chi phí, năng lượng và bảo mật được đề cập ở trên.

NIC nền tảng hạn chế khả năng của nền tảng Cơ sở hạ tầng dưới dạng dịch vụ

Các nhà điều hành trung tâm dữ liệu doanh nghiệp và đám mây muốn cung cấp nền tảng Cơ sở hạ tầng dưới dạng dịch vụ (IaaS) cho khách hàng hoặc “người thuê” của mình theo truyền thống buộc phải lựa chọn giữa hai phương pháp tiếp cận kiến trúc.

Bằng cách dành riêng toàn bộ máy chủ vật lý cho một người thuê duy nhất, họ có thể đảm bảo hiệu suất tính toán tối đa có sẵn từ CPU của máy chủ đó, cùng với hoạt động hoàn toàn xác định và cách ly hoàn toàn khỏi tất cả những người thuê trung tâm dữ liệu khác. Tuy nhiên, người vận hành có thể mất vài giờ để cung cấp máy chủ cho trải nghiệm “bare metal” thực sự này, trong thời gian đó máy chủ không được sử dụng và không tạo ra doanh thu. Quy trình cung cấp vật lý cũng hạn chế khả năng phản hồi nhanh chóng của người vận hành đối với các đơn đặt hàng mới của khách hàng hoặc các yêu cầu thay đổi động, trong khi khả năng mở rộng cấu hình của khách hàng vốn đã bị hạn chế. Nhìn chung, việc sử dụng máy chủ vật lý để cung cấp nền tảng IaaS dẫn đến mô hình OPEX không lý tưởng cho người vận hành.

Máy chủ chuẩn chạy Virtual Server Instance

Phương án thay thế truyền thống là cung cấp nền tảng dưới dạng “Virtual Server Instance” hoặc “VSI” chạy trên máy chủ chuẩn được cấu hình với một Network Interface Card (NIC) cơ bản, để khách hàng có thể truy cập vào Virtual Machine (VM) thay vì các lõi CPU vật lý, dưới sự kiểm soát của một hypervisor. (Thông thường, hypervisor bare metal “Type 1” được sử dụng cho các ứng dụng IaaS, thay vì hypervisor “Type 2” chạy trên hệ điều hành.)

Ưu điểm của việc triển khai VSI là việc cung cấp diễn ra nhanh chóng (thường chỉ mất vài phút hoặc thậm chí vài giây) giúp giảm thiểu thời gian ngừng hoạt động của máy chủ, trong khi nền tảng có khả năng mở rộng và tùy chỉnh cao khi nhu cầu của khách hàng thay đổi.

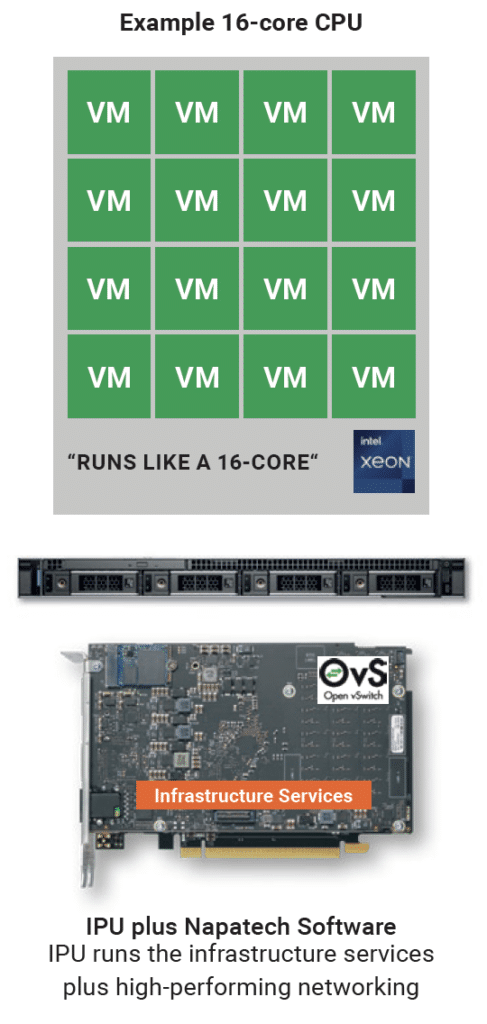

Tuy nhiên, có một số nhược điểm quan trọng đối với phương pháp VSI. Một phần đáng kể lõi CPU được yêu cầu để chạy các dịch vụ cơ sở hạ tầng như ngăn xếp mạng, bộ chuyển mạch ảo (vSwitch) và các chức năng khác như trình quản lý ảo, giới hạn số lượng lõi CPU có thể được kiếm tiền cho VM. Ví dụ, một CPU 16 lõi chỉ có thể cung cấp hiệu suất của một CPU 8 lõi.

vSwitch kết nối các VM hoặc container với cả mạng ảo và mạng vật lý, đồng thời kết nối lưu lượng “Đông-Tây” giữa các VM hoặc container. Có sẵn vSwitch dựa trên phần mềm, với Open vSwitch – Data Plane Development Kit (OVS-DPDK) là vSwitch được sử dụng rộng rãi nhất do hiệu suất được tối ưu hóa mà nó đạt được thông qua việc sử dụng các thư viện phần mềm DPDK cũng như tính khả dụng của nó như một dự án nguồn mở tiêu chuẩn.

Ngoài ra, vì người thuê không thể truy cập toàn bộ CPU nên kiến trúc này không phải là một đám mây bare metal thực sự. Có nguy cơ bảo mật nếu hypervisor hoặc vSwitch bị xâm phạm trong một cuộc tấn công mạng, trong khi không có cách nào để đảm bảo cô lập hoàn toàn giữa các khối lượng công việc của người thuê.

Cuối cùng, cách tiếp cận này mang lại hiệu suất mạng hạn chế vì NIC cơ bản không có khả năng tăng tốc ngăn xếp bằng cách chuyển tải nó khỏi CPU.

Chuyển giao IPU cho các đám mây bare metal hiệu suất cao

Cách tiếp cận tốt nhất để cung cấp IaaS là sử dụng Đơn vị xử lý cơ sở hạ tầng (IPU) thay vì NIC nền tảng. IPU bao gồm FPGA để thực hiện các chức năng của mặt phẳng dữ liệu như Lớp 2 và 3 của ngăn xếp mạng, cũng như CPU mục đích chung cho khối lượng công việc của mặt phẳng điều khiển cũng như Từ 4 đến 7 sau của ngăn xếp và trình quản lý ảo.

Các dịch vụ cơ sở hạ tầng như hypervisor, vSwitch và giao thức mạng có thể được chuyển hoàn toàn sang SmartNIC, do đó tất cả các lõi CPU đều khả dụng (và có thể kiếm tiền) để chạy VM của người thuê, đảm bảo hiệu suất tính toán tối đa. Trong ví dụ này, CPU 16 lõi thực sự chạy như một CPU 16 lõi.

Kiến trúc này cho phép triển khai các đám mây bare metal ảo hóa, đa thuê bao để hỗ trợ mô hình kinh doanh IaaS, với hiệu suất hoàn toàn xác định cho từng thuê bao và không có nguy cơ bị nhiễu do “các thiết bị lân cận gây nhiễu”.

Trong kịch bản nhiều đối tượng thuê, tài nguyên điện toán có thể được chia nhỏ và phân bổ động dựa trên nhu cầu cụ thể của từng đối tượng thuê, với mức độ chi tiết cao hơn và cung cấp nhanh hơn so với VSI.

Đồng thời, IPU đảm bảo hiệu suất mạng tối đa bằng cách chuyển giao tất cả các giao thức và chức năng bảo mật cần thiết được thực hiện trên CPU máy chủ trong tình huống VSI.

Kiến trúc nền tảng IPU này hỗ trợ mô hình triển khai cực kỳ linh hoạt cho phép các nhà điều hành trung tâm dữ liệu tối đa hóa ROI từ các dịch vụ IaaS của họ. Giống như trong kịch bản VSI, việc cung cấp diễn ra nhanh chóng (thường chỉ mất vài phút hoặc thậm chí vài giây) giúp giảm thiểu thời gian ngừng hoạt động của máy chủ, trong khi nền tảng có khả năng mở rộng và tùy chỉnh cao khi nhu cầu của khách hàng thay đổi. Ngoài ra, các dịch vụ cơ sở hạ tầng có thể nâng cấp hoàn toàn bằng phần mềm, do đó không có nguy cơ bị khóa phần cứng, giúp tối đa hóa tuổi thọ hiệu quả của cả máy chủ và IPU.

Giải pháp chuyển tải mạng của Napatech

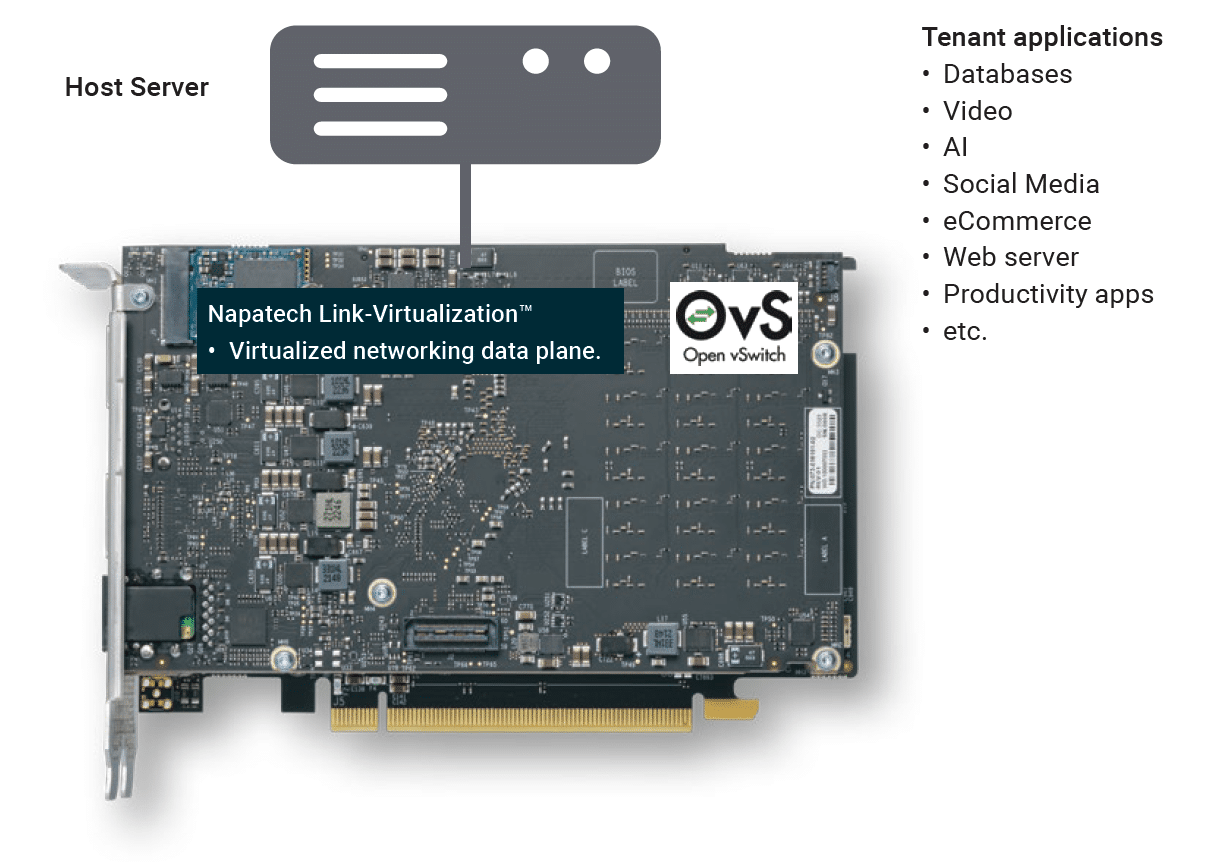

Napatech cung cấp giải pháp tích hợp cấp hệ thống để chuyển tải mạng trung tâm dữ liệu, bao gồm ngăn xếp phần mềm mặt phẳng dữ liệu ảo hóa Link-Virtualization™ hiệu suất cao chạy trên IPU F2070X.

Link-Virtualization hoàn toàn tương thích với giao diện mạng virtio-net và các API tiêu chuẩn công nghiệp hiện hành như DPDK, do đó không cần thay đổi bất kỳ ứng dụng khách nào để tận dụng hiệu suất mà giải pháp Napatech mang lại.

Xem thanh bên để biết thông tin chi tiết về phần cứng IPU F2070X.

Phần mềm Link-Virtualization tích hợp nhiều chức năng phong phú, bao gồm:

- Dỡ bỏ toàn bộ Open vSwitch (OVS) từ máy chủ sang IPU, với mặt phẳng dữ liệu OVS chạy trên FPGA và mặt phẳng điều khiển trên Intel® Xeon® D SoC.

- Đóng gói và giải nén VLAN và VxLAN:

- Đường hầm L2: IEEE 802.1Q VLAN và Q-in-Q (IEEE 802.1ad);

- Đường hầm L3: VXLAN.

- Tăng tốc đường dẫn dữ liệu ảo (vDPA), cho phép di chuyển trực tiếp các máy ảo khách (thuê) trong khi vẫn duy trì hiệu suất cao và độ trễ thấp của Ảo hóa I/O gốc đơn (SR-IOV).

- Phản chiếu cổng.

- Cân bằng tải RSS.

- Tổng hợp liên kết.

- Giới hạn tốc độ cổng cho Chất lượng dịch vụ (QoS):

- Giới hạn tốc độ truyền trên cơ sở VF của Chức năng ảo hoặc Chức năng vật lý (PF);

- Nhận mức giới hạn tỷ lệ theo từng VF.

- Lớp cô lập bảo mật giữa CPU chủ và IPU.

Do không sử dụng lõi CPU máy chủ cho mặt phẳng dữ liệu ảo hóa, nền tảng này cho phép triển khai cả đám mây đơn thuê và đa thuê với khả năng cô lập hoàn toàn, bảo vệ và duy trì mô hình quản lý mạng và cấu trúc mạng.

Vì F2070X dựa trên FPGA và CPU thay vì ASIC, nên toàn bộ chức năng của nền tảng có thể được cập nhật sau khi triển khai, cho dù là để sửa đổi dịch vụ hiện có, để thêm chức năng mới hay để tinh chỉnh các thông số hiệu suất cụ thể. Việc lập trình lại này có thể được thực hiện hoàn toàn như một bản nâng cấp phần mềm trong môi trường máy chủ hiện có, không cần phải ngắt kết nối, tháo hoặc thay thế bất kỳ phần cứng nào.

Giải pháp phần cứng cộng với phần mềm tích hợp của Napatech, bao gồm ngăn xếp phần mềm Link-Virtualization chạy trên IPU F2070X, giải quyết vấn đề này bằng cách chuyển tải ngăn xếp mạng từ CPU máy chủ sang Đơn vị xử lý cơ sở hạ tầng (IPU) trong khi vẫn duy trì khả năng tương thích phần mềm hoàn toàn ở cấp ứng dụng.

Hiệu suất hàng đầu trong ngành

Giải pháp chuyển tải lưu trữ dựa trên Napatech F2070X mang lại hiệu suất hàng đầu trong ngành về các tiêu chuẩn liên quan đến các trường hợp sử dụng trung tâm dữ liệu, bao gồm tổng dung lượng chuyển mạch là 300 triệu gói mỗi giây (Mpps) trong cấu hình cổng-đến-cổng với các gói 64 byte (tốc độ đường truyền).

Lưu ý rằng các tiêu chuẩn trên chỉ là sơ bộ khi chưa có phần cứng và phần mềm chính thức.